Pesquisadores de cibersegurança descobriram uma falha de segurança crítica em um provedor de inteligência artificial (IA) como serviço Replicate que poderia ter permitido que atores maliciosos tivessem acesso a modelos de IA patenteados e informações sensíveis.

“A exploração dessa vulnerabilidade teria permitido acesso não autorizado aos prompts de IA e aos resultados de todos os clientes da plataforma do Replicate,” disse a empresa de segurança em nuvem Wiz em um relatório publicado recentemente.

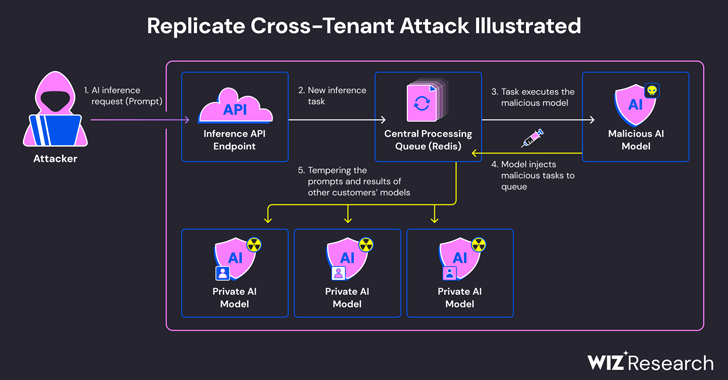

A questão decorre do fato de que os modelos de IA geralmente são empacotados em formatos que permitem a execução de código arbitrário, o que um atacante poderia usar para realizar ataques entre inquilinos por meio de um modelo malicioso.

Replicate faz uso de uma ferramenta de código aberto chamada Cog para containerizar e empacotar modelos de aprendizado de máquina que podem ser implantados em um ambiente auto-hospedado ou no Replicate.

Wiz afirmou ter criado um contêiner Cog falso e o carregado no Replicate, utilizando-o posteriormente para obter execução de código remoto na infraestrutura do serviço com privilégios elevados.

“Acreditamos que essa técnica de execução de código é um padrão, no qual empresas e organizações executam modelos de IA de fontes não confiáveis, mesmo que esses modelos contenham código potencialmente malicioso,” disseram os pesquisadores de segurança.

A técnica de ataque desenvolvida pela empresa aproveitou uma conexão TCP já estabelecida associada a uma instância do servidor Redis dentro do cluster Kubernetes hospedado na Google Cloud Platform para injetar comandos arbitrários.

Além disso, com o servidor Redis centralizado sendo usado como fila para gerenciar várias solicitações de clientes e suas respostas, os pesquisadores descobriram que ele poderia ser abusado para facilitar ataques entre inquilinos, manipulando o processo para inserir tarefas falsas que poderiam impactar os resultados dos modelos de outros clientes.

Essas manipulações falsas não apenas ameaçam a integridade dos modelos de IA, mas também representam riscos significativos para a precisão e confiabilidade das saídas orientadas por IA.

“Um atacante poderia consultar os modelos de IA privados dos clientes, potencialmente expondo conhecimento proprietário ou dados sensíveis envolvidos no processo de treinamento do modelo,” disseram os pesquisadores. “Além disso, a interceptação dos prompts poderia expor dados sensíveis, incluindo informações de identificação pessoal (IIP).

A vulnerabilidade, que foi divulgada de forma responsável em janeiro de 2024, desde então foi corrigida pelo Replicate. Não há evidências de que a vulnerabilidade tenha sido explorada para comprometer dados de clientes.

A divulgação ocorre pouco mais de um mês depois que a Wiz detalhou riscos agora corrigidos em plataformas como Hugging Face que poderiam permitir que atores maliciosos escalassem privilégios, ganhassem acesso entre inquilinos aos modelos de outros clientes e até assumissem os pipelines de integração e implantação contínuas da produção (CI/CD).

“Modelos maliciosos representam um grande risco para sistemas de IA, especialmente para provedores de IA como serviço, porque os atacantes podem usar esses modelos para realizar ataques entre inquilinos,” concluíram os pesquisadores.

“O impacto potencial é devastador, pois os atacantes podem acessar os milhões de modelos de IA privados e aplicativos armazenados nos provedores de IA como serviço.”