Pesquisadores de cibersegurança descobriram uma falha de segurança crítica em um provedor de inteligência artificial (IA)-como-serviço Replicate que poderia permitir que atores maliciosos obtivessem acesso a modelos de IA proprietários e informações sensíveis.

“A exploração dessa vulnerabilidade teria permitido acesso não autorizado aos prompts de IA e resultados de todos os clientes da plataforma Replicate”, disse a empresa de segurança em nuvem Wiz em um relatório publicado esta semana.

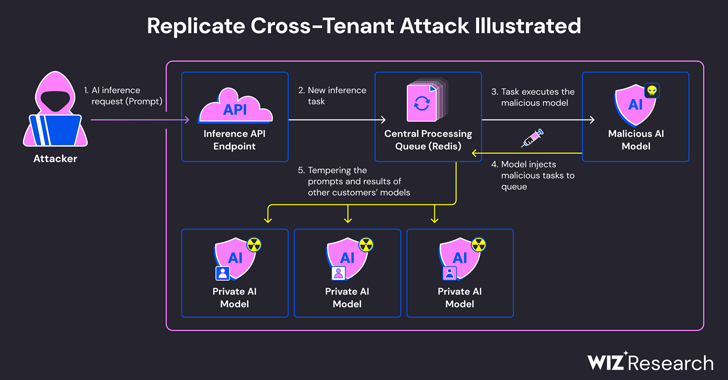

O problema decorre do fato de que os modelos de IA geralmente são empacotados em formatos que permitem a execução de código arbitrário, o que um atacante poderia usar para realizar ataques entre inquilinos por meio de um modelo malicioso.

Replicate usa uma ferramenta de código aberto chamada Cog para containerizar e empacotar modelos de aprendizado de máquina que podem ser implantados em um ambiente auto-hospedado ou no Replicate.

Wiz afirmou ter criado um contêiner Cog falso e o carregou no Replicate, empregando-o para obter execução remota de código na infraestrutura do serviço com privilégios elevados.

“Acreditamos que essa técnica de execução de código é um padrão, no qual empresas e organizações executam modelos de IA de fontes não confiáveis, mesmo que esses modelos sejam código que poderia ser potencialmente malicioso”, afirmaram os pesquisadores de segurança.

A técnica de ataque desenvolvida pela empresa então utilizou uma conexão TCP já estabelecida associada a uma instância do servidor Redis dentro do cluster Kubernetes hospedado na Google Cloud Platform para injetar comandos arbitrários.

Além disso, com o servidor Redis centralizado sendo usado como uma fila para gerenciar várias solicitações de clientes e suas respostas, os pesquisadores descobriram que poderia ser abusado para facilitar ataques entre inquilinos, alterando o processo para inserir tarefas falsas que poderiam afetar os resultados de modelos de outros clientes.

Essas manipulações fraudulentas não apenas ameaçam a integridade dos modelos de IA, mas também representam riscos significativos para a precisão e confiabilidade das saídas orientadas por IA.

Um ponto fraco, que foi divulgado de forma responsável em janeiro de 2024, foi corrigido pelo Replicate. Não há evidências de que a vulnerabilidade tenha sido explorada na natureza para comprometer dados do cliente.

A divulgação ocorre pouco mais de um mês após a Wiz detalhar riscos agora corrigidos em plataformas como Hugging Face que poderiam permitir que atores maliciosos escalassem privilégios, obtivessem acesso entre inquilinos aos modelos de outros clientes e até assumissem os pipelines de integração e implantação contínuas (CI/CD).

“Modelos maliciosos representam um grande risco para sistemas de IA, especialmente para provedores de IA-como-serviço, pois os atacantes podem usar esses modelos para realizar ataques entre inquilinos”, concluíram os pesquisadores.

“O impacto potencial é devastador, pois os invasores podem ter acesso aos milhões de modelos e aplicativos de IA privados armazenados nos provedores de IA-como-serviço.”